前几天的时候,发现博客被百度拔毛了,当时以为是百度云CDN与境外VPS的连通性不好,于是重新修改了DNS和CDN。

但是越想感觉越不对,用CDN的人也不再少数,CDN想必也不会那么弱吧。

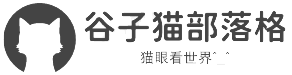

今天在宝塔面板查询蜘蛛日志的时候,终于发现了异常:几家的蜘蛛都爬一个不应该存在的php文件。

我复制了蜘蛛抓取的地址 /wap.php?m=79889**,直接浏览器输入后显示404.

不应该啊,如果不存在的文件,蜘蛛为啥爬那么欢快,一只只的接着爬?

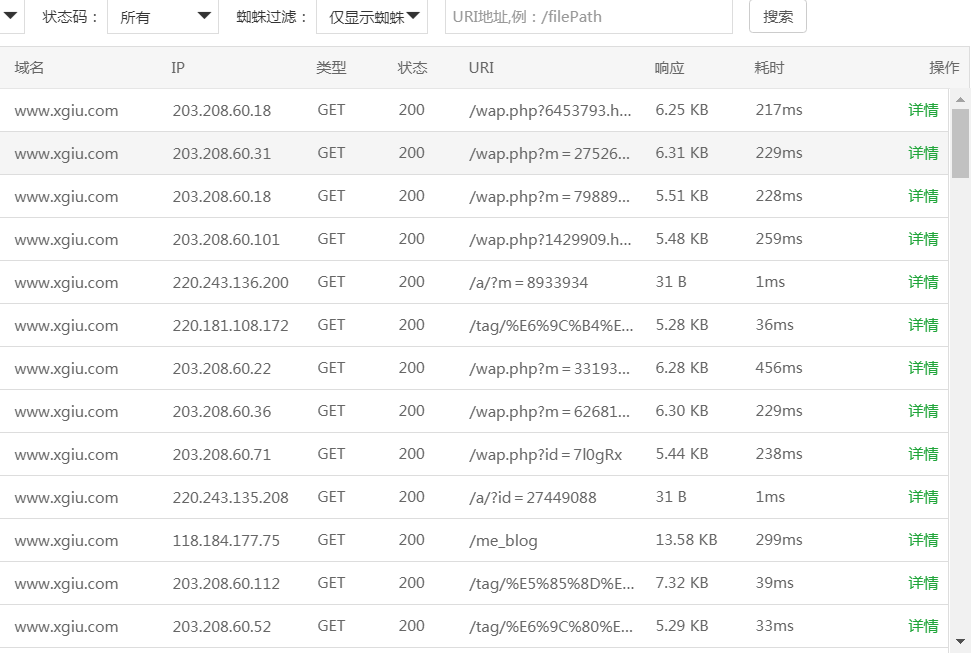

进文件管理器,那个wap.php竟然真的存在。![]()

除了这个wap.php,另外一个蜘蛛爬的非正常目录也存在,根目录下的 /a/index.php 也是一个可执行文件。

这两个文件的内容基本一致,依据访问来源的UA,劫持搜索引擎的蜘蛛。

<?php

header('Content-Type:text/html;charset=utf-8');

$key= $_SERVER["HTTP_USER_AGENT"];

if(strpos($key,'baidu')!==false||strpos($key,'haosou')!==false||strpos($key,'sogou')!==false||strpos($key,'360')!==false)

//{

// $file = file_get_contents('http://***.hnjq88*.com/***/');

// echo $file;//

//}

?>

基本就是依据来访的UA,如果正常访问,那么博客展示内容也正常,如果是蜘蛛来爬,则给蜘蛛展示那个坏蛋自己的网站内容。

既然找到了不相干的文件,那么肯定也有文件被修改。

在关注文件日期之后,发现配置文件config.php被修改,因为在EMLOG程序中,基本页面一打开都会读取config.php里面的内容,每次如果蜘蛛到访,就引用到被恶意上传的两个文件wap.php和/a/index.php....

这次的被黑很隐蔽,也非常有迷惑性,正常在客户端访问一直都是正常,单单劫持搜索引擎的蜘蛛,菜鸟真的是很无奈。

解决方法:

1:修改robots.txt, 把那两个位置禁止掉。

User-agent: *2:删除恶意文件wap.php和/a/index.php

Disallow: /wap.php

Disallow: /a/

3:删除config.m.php和config.php里面的恶意代码,仅保留数据库文件。

修改过后,等着蜘蛛再来吧...

谷子猫博客

谷子猫博客

发表评论