搜索引擎疑似对CDN站点抓取不友善?如何改善搜索引擎抓取情况?

有的站长可能发现了,切换CDN后搜索引擎的收录变少了,权重降低了。

然后跟谷子一样,以为是搜索引擎对CDN不友善。

其实呢,到现在网络环境变好了,搜索引擎的蜘蛛不再像以前,现在针对CDN使用站已经很友善了。谷子的站长期套用CDN加速,目前在搜狗神马等站权重都还可以。

那么很多站长感觉更换CDN后,感觉对网站收录不友好的原因是什么呢?

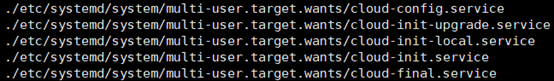

1:CDN节点多,搜索引擎回源不稳定。

以网宿,火山为例,他们的CDN为了广覆盖,一次分配30+节点。源站或者CDN设置错误说不定就干扰到了蜘蛛爬取。

而且部分搜索引擎蜘蛛拥有不同的IP段。以百度的蜘蛛为例,百度蜘蛛主要两个网络段,一个电信北京节点,一个山西阳泉联通节点,抓取不同的节点网络波动不同。

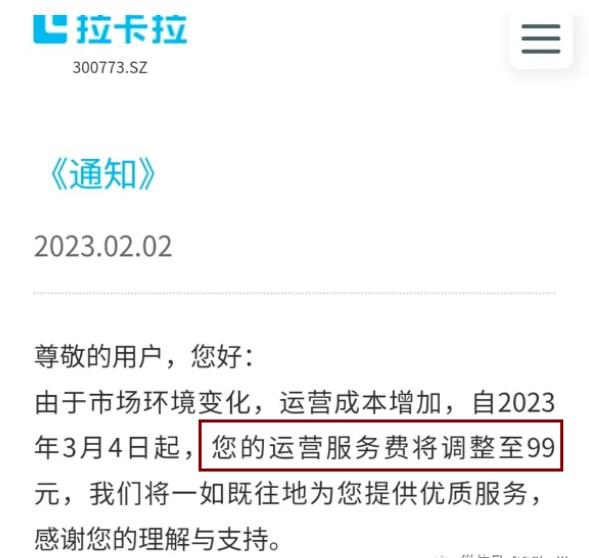

2:CDN服务商节点变化快。

现在服务商提供CDN服务方式,大部分是分配一个CNAME。服务器给CNAME依据线路等设置不同的解析指向不同的节点。

部分服务器同时提供普通节点和高防节点,被攻击会切换解析IP。IP变动太频繁,蜘蛛会认为源站不稳定。

3:CDN部分节点忽然失效。

这点对于蜘蛛影响最大,因为中小CDN服务商对于风险抵抗力较低,部分节点甚至离线后才会得到通知然后告知客户。

此时蜘蛛因为DNS缓存原因,还会在后续几天继续爬取失效的节点。

那么要怎样做?

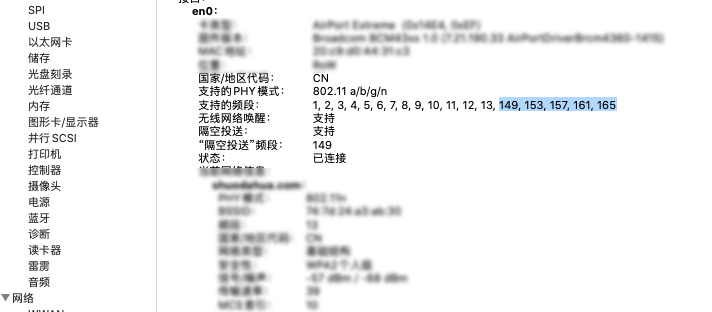

最好的是使用CDN后,针对搜索引擎做一个解析。目前DNSPOD,阿里云DNS等都有这样的功能。

单独解析的IP,最好做到快速稳定(国内节点可以直接回源),这样即使CDN节点变动也不会影响到收录。

谷子猫博客

谷子猫博客

发表评论